ollama

- 访问 Ollama Windows Preview 页面,下载并安装

- 启动 Ollama 并获取模型,

ollama run [modelname]- 连接到 Ollama API

我们不可能只通过命令行来使用,将应用程序连接到 Ollama API 是一个非常重要的步骤。这样就可以把 AI 的功能整合到自己的软件里,或者在 OpenAI Translator 和 NextChat 这类的前端工具中进行调用。

以下是如何连接和使用 Ollama API 的步骤:

- 默认地址和端口:Ollama API 的默认地址是

http://localhost:11434,可以在安装 Ollama 的系统中直接调用。 - 修改 API 的侦听地址和端口:如果要在网络中提供服务,可以修改 API 的侦听地址和端口。

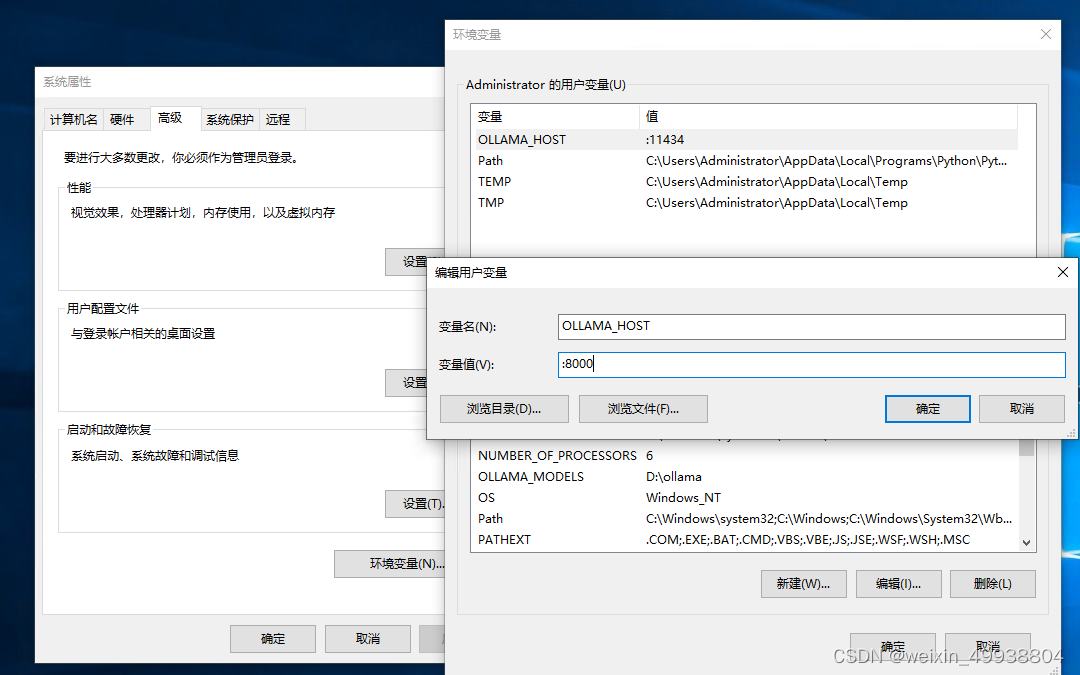

1右击点击任务栏图标,选择「Quit Ollama」退出后台运行。

2使用Windows + R快捷键打开「运行」对话框,输入命令:sysdm.cpl

系统属性→环境变量→用户变量,新增变量记录:

常用命令

# 查看 Ollama 版本

ollama -v

# 查看已安装的模型

ollama list

# 删除指定模型

ollama rm [modelname]

# 模型存储路径

# C:\Users\<username>\.ollama\models